Introducción a la Tecnología de Cámaras Digitales

La mayoría de las técnicas modernas requieren el uso de una cámara digital. Al trabajar con dispositivos digitales, los investigadores pueden observar especímenes en tiempo real en una pantalla o adquirir y almacenar imágenes y datos cuantificables. Desde imágenes básicas en campo claro hasta avanzadas técnicas de superresolución, una amplia gama de aplicaciones depende de cámaras. El rendimiento y la variedad de tecnologías de cámaras digitales disponibles han aumentado considerablemente, ofreciendo a los investigadores una amplia gama de detectores para abordar sus necesidades científicas. La elección de los sensores de imagen digitales puede tener un impacto sustancial en las características de la imagen, por lo que es importante comprender los principios básicos de cómo funcionan y en qué se diferencian entre sí. Aquí presentamos los principios básicos detrás de las tecnologías de cámaras digitales comúnmente encontradas en la imagen científica.

Fundamentos

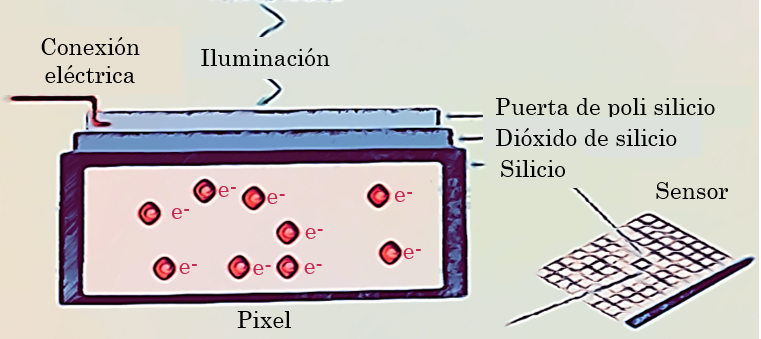

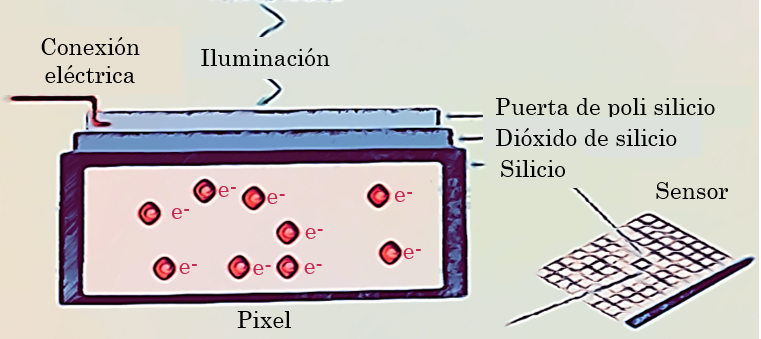

La tarea de un sensor de imagen es convertir una señal óptica en una señal eléctrica. Este principio se basa en el llamado efecto fotovoltaico, que describe cómo los fotones interactúan con el material para liberar un electrón que resulta en la acumulación de carga. En la mayoría de las cámaras, el silicio es el sustrato utilizado para este propósito. En todos los casos, un electrón se libera de su enlace mediante la absorción de un fotón. Las propiedades naturales del silicio lo hacen ideal como el componente principal de la unidad elemental de la mayoría de los sensores.

Píxel

Independientemente del tipo de sensor, se puede considerar el píxel como la unidad básica. El elemento principal de un píxel es el fotodiodo fotosensible con silicio acoplado a un pozo de almacenamiento de electrones. El silicio es responsable de generar los electrones, que luego se pueden recoger, mover y finalmente convertir en una señal digital. Los componentes adicionales de un píxel incluyen circuitos de control eléctrico y capas de pigmentos para excluir longitudes de onda no deseadas o destructivas. Durante el proceso de imagen, los fotones que impactan en los fotodiodos se convierten en electrones. Estos electrones se almacenan en los pozos de almacenamiento de electrones para su transferencia posterior, la lectura, al amplificador. El amplificador lee los electrones acumulados y los transforma en un voltaje, mientras que el convertidor analógico-digital (AD) adyacente realiza la digitalización y produce señales digitales equivalentes.

La carga generada en un píxel es directamente proporcional al número de fotones que golpean el sensor, lo cual suele estar influenciado por la duración de la exposición a la luz (tiempo de integración), la longitud de onda detectada y, lo más importante, la intensidad de la luz. Como regla general, el tamaño del píxel define la cantidad de electrones que se pueden recoger sin saturar un píxel. El tamaño de los píxeles varía típicamente entre 2-24 µm² para sensores de imagen en microscopía.

Debido a las arquitecturas típicas de los píxeles, no toda la superficie de un píxel es fotosensible. El factor de llenado de un sensor de imagen describe la relación entre el área fotosensible de un píxel y su área total. Se pueden agregar micro lentes a un píxel para enfocar mejor la luz en las regiones fotosensibles, mejorando el factor de llenado.

Un sensor de imagen digital completo consta de millones de píxeles organizados en una matriz geométrica. A menudo, se confunde el número de píxeles con «resolución». Es importante destacar que no es simplemente el número de píxeles, sino su tamaño lo que define la resolución del chip de la cámara. En general, píxeles más pequeños ofrecerán una mayor resolución que los grandes. En última instancia, la resolución de una Un sensor completo de imagen digital consta de millones de píxeles organizados en una matriz geométrica. Con frecuencia, se confunde el número de píxeles con «resolución». Es importante destacar que no es simplemente el número de píxeles, sino su tamaño lo que define la resolución del chip de la cámara. En general, píxeles más pequeños proporcionarán una mayor resolución que los más grandes. En última instancia, la resolución de un sistema de microscopía no depende solo del conjunto de sensores, sino del sistema óptico completo.

Ruido y relación señal-ruido

Desafortunadamente, el ruido es un elemento fundamental de la física que afecta todas las señales. El impacto y el tipo de ruido dominante varían según los tipos de sensores. En general, se puede clasificar el ruido de la cámara en tres clases principales según su origen:

1. Ruido oscuro: también conocido como corriente oscura, es un ruido fundamental presente en el sensor debido a la energía térmica en el silicio que genera electrones de manera aleatoria en los píxeles. Este tipo de ruido se acumula con el tiempo de exposición y se expresa en electrones por píxel por segundo (e-/px/seg). Es menos preocupante para aplicaciones rápidas con tiempos de exposición cortos, pero puede convertirse en un problema importante para tiempos de exposición largos, por ejemplo, un segundo o más para señales fluorescentes débiles. La reducción del ruido oscuro se logra enfriando el sensor, reduciendo a la mitad la corriente oscura con cada 8 grados de enfriamiento.

2. Ruido de lectura: proviene de la circuitería eléctrica de lectura del sensor involucrada en cuantificar la señal. Como regla general, el ruido de lectura se puede reducir disminuyendo la velocidad de lectura del píxel, que define qué tan rápido se puede leer la carga del sensor (unidad: MHz). Dado que esto determina la velocidad de cuadros de la cámara, el ruido de lectura debe tenerse en cuenta para experimentos rápidos, como el lapso de tiempo de células vivas de alta velocidad.

3. Ruido de conteo de fotones: es otra fuente de ruido basada en la incertidumbre al contar los fotones entrantes. Surge de la naturaleza estocástica de los impactos de los fotones en el sensor, pero no es introducido por el sensor en sí. Se puede visualizar como una distribución de Poisson al detectar fotones en el chip.

Bajo condiciones de poca luz, como en la imagen de fluorescencia cuando la intensidad de la señal es baja, las diferentes fuentes de ruido pueden tener un impacto importante en la calidad de la imagen, ya que afectan la relación señal-ruido. Utilizar la cámara adecuada para la aplicación es esencial para capturar imágenes de calidad. La relación señal-ruido (SNR) es una medida de la calidad general de una imagen, que está fuertemente influenciada por el tipo de sensor. En términos generales, se puede designar como su sensibilidad. Aunque esto puede ser bastante complejo, la SNR expresa qué tan bien se distingue una señal de interés del ruido de fondo.

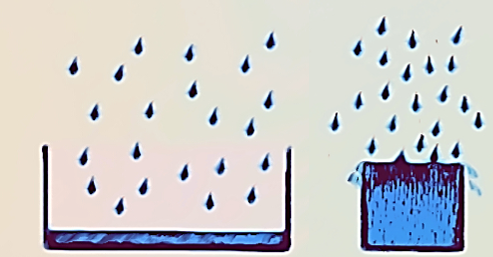

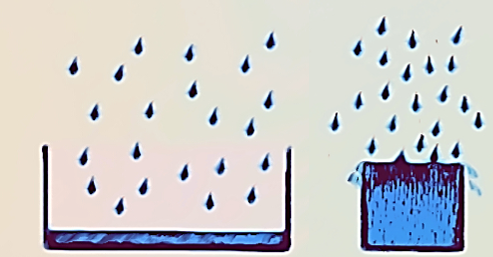

Capacidad del pozo

La capacidad del pozo depende en gran medida del tamaño físico del píxel. Se refiere a la capacidad de almacenamiento de carga de un solo píxel, es decir, el número máximo de electrones que puede recoger antes de saturarse. Alcanzar la capacidad completa del pozo se puede comparar con un cubo lleno de agua. Los píxeles más grandes tienen una capacidad completa del pozo mayor que los píxeles pequeños (típicamente 18,000 e- para un píxel de 6.45 µm frente a 300,000 e- para un píxel de 24 µm). La resolución espacial se sacrifica por la mayor capacidad completa del pozo, lo que a su vez influye en el rango dinámico.

Los electrones que exceden la capacidad completa del pozo no se pueden cuantificar. En algunos casos, la carga puede filtrarse hacia los píxeles adyacentes, causando un efecto conocido como florecimiento. Algunos sensores contienen electrónicos anti florecimiento que intentan eliminar la carga excesiva para suprimir artefactos de florecimiento.

Rango dinámico

Una característica directamente relacionada con la capacidad completa del pozo es el rango dinámico. Esto describe la capacidad del sensor para registrar simultáneamente señales de baja y alta intensidad. En un sentido práctico, esto significa que la señal más débil no se pierde en el ruido y la señal más brillante no satura el sensor. Expresado en términos matemáticos, el rango dinámico se define como la capacidad completa del pozo (FWC) dividida por el ruido de la cámara.

La mejora del rango dinámico se logra si la capacidad completa del pozo es mayor y el ruido de la cámara es menor. En una primera aproximación, se puede decir que los siguientes parámetros afectan el rango dinámico:

1. Tamaño del píxel (Capacidad completa del pozo)

2. Temperatura (Ruido oscuro)

3. Tasa de lectura (Ruido de lectura)

Para aplicaciones de fluorescencia, un rango dinámico grande es un beneficio importante para documentar señales brillantes de fluorescencia contra un fondo oscuro (Fig. 7), especialmente al cuantificar señales. El rango dinámico se ve directamente afectado por la ganancia aplicada. El término «ganancia» se usa aquí para expresar la amplificación de una señal generada. Si, por ejemplo, duplicas la ganancia de tu sensor, efectivamente reduces a la mitad la capacidad completa del pozo, lo que a su vez disminuye el rango dinámico. Por lo tanto, a menudo se requiere un equilibrio entre sensibilidad y rango dinámico. Si el rango dinámico inherente del sensor no es suficiente para la aplicación, o el espécimen, se puede considerar una adquisición de «alto rango dinámico» (HDR). Durante este procedimiento, se adquiere una serie de imágenes con intensidades de exposición variables. La imagen resultante se calcula finalmente aplicando diferentes algoritmos. La desventaja de este enfoque es el tiempo prolongado necesario para adquirir las imágenes. Por lo tanto, esto no es preferible para muestras que se mueven rápidamente o son sensibles a la luz.

Eficiencia cuántica

En un mundo ideal, se asumiría que 100 fotones son capaces de generar 100 electrones. Al interactuar con un sensor, los fotones pueden ser absorbidos, reflejados o incluso pasar directamente a través. La capacidad de un sensor para absorber y convertir la luz de una longitud de onda determinada en electrones se conoce como su eficiencia cuántica (QE).

La eficiencia cuántica de un sensor se ve afectada por varios factores, incluyen:

1. Factor de llenado

2. Adición / rendimiento de micro lentes

3. Recubrimiento antirreflejante

4. Formato del sensor (iluminado por la parte trasera o delantera)

La eficiencia cuántica es siempre una función de la longitud de onda de la luz entrante. Los detectores de silicio, más comúnmente utilizados en imágenes científicas, pueden detectar longitudes de onda justo más allá del rango de luz visible (~400 a 1000 nm). Al observar una curva de eficiencia cuántica, puedes ver cuán eficiente es un sensor específico para convertir una longitud de onda particular en una señal (Fig. 9). La mayoría de los sensores de cámaras están iluminados por la parte delantera, donde la luz incidente entra desde el frente del píxel, teniendo que pasar capas semitransparentes que contienen la circuitería de los píxeles, antes de golpear el silicio fotosensible. Estas capas causan cierta pérdida de luz, por lo que los sensores iluminados por la parte delantera suelen tener eficiencias cuánticas máximas alrededor del 50-60%. Dado que la electrónica en la superficie de los sensores solo puede generar un campo eléctrico localizado, no puede manipular la carga que se forma más profundamente en la oblea de silicio.

En el caso de un sensor iluminado por la parte trasera, la luz golpea directamente el silicio fotosensible desde la «parte trasera» sin tener que pasar por la circuitería del píxel, ofreciendo eficiencias cuánticas máximas que se acercan al 95%. Para fabricar sensores iluminados por la parte trasera, también conocidos como retroiluminados, este silicio adicional se muele, un proceso costoso, para crear una capa de silicio increíblemente delgada donde todos los píxeles pueden manipular la carga de manera efectiva.

Profundidad de bits

La profundidad de bits puede relacionarse con, pero no debe confundirse con el rango dinámico, y se refiere a cómo se digitaliza, o se divide, la señal analógica en valores de escala de grises o niveles de grises. La profundidad de bits depende de la capacidad del convertidor AD para transformar la cantidad de electrones generados en valores de escala de grises. Cuantos más niveles de grises pueda producir, más detalles se pueden reproducir.

Algunas cámaras ofrecen más valores de escala de grises de los necesarios para el número máximo de electrones que pueden generar los fotones (por ejemplo, una digitalización de 16 bits divide la señal en ~65,000 unidades de escala de grises). En circunstancias extremas, el sensor puede saturarse por debajo de 1,000 fotones/píxel, pero la imagen aún muestra 65,000 valores de escala de grises. Además, las pantallas de computadora suelen ser capaces de mostrar datos de 8 bits. Es por eso que una señal de cámara con más de 8 bits debe reducirse para mostrarse. Los usuarios pueden influir en este proceso con la ayuda de la tabla de búsqueda (LUT). Jugar con ella a menudo revela detalles ocultos en una imagen.

Velocidad de imagen y binning

La velocidad de imagen de una cámara digital se mide en tasas de cuadros indicadas en cuadros por segundo (fps). Este es el número de imágenes (cuadros) que la cámara puede adquirir en un segundo. Muchos factores pueden afectar la velocidad máxima alcanzable de una cámara. En un tiempo de exposición dado, se deben considerar los siguientes parámetros:

1. Recuento de píxeles

2. Tasa de lectura de píxeles

3. Interfaz de la computadora

Resumen

La microscopía óptica moderna sería impensable sin la tecnología de cámaras digitales. La mayoría de los usuarios de microscopios desean observar sus especímenes en tiempo real en un monitor o guardar y procesar sus descubrimientos en una computadora. Además, algunas técnicas microscópicas, como la microscopía de localización, ni siquiera habrían sido posibles sin el surgimiento de los sensores de cámaras digitales. El lector de este artículo debería haber aprendido cómo se producen las imágenes microscópicas digitales. Esto, a su vez, ayudará a utilizar una cámara digital adecuadamente y a interpretar los datos generados de la manera correcta.

Introducción a la Tecnología de Cámaras Digitales

La mayoría de las técnicas modernas requieren el uso de una cámara digital. Al trabajar con dispositivos digitales, los investigadores pueden observar especímenes en tiempo real en una pantalla o adquirir y almacenar imágenes y datos cuantificables. Desde imágenes básicas en campo claro hasta avanzadas técnicas de superresolución, una amplia gama de aplicaciones depende de cámaras.

El rendimiento y la variedad de tecnologías de cámaras digitales disponibles han aumentado considerablemente, ofreciendo a los investigadores una amplia gama de detectores para abordar sus necesidades científicas. La elección de los sensores de imagen digitales puede tener un impacto sustancial en las características de la imagen, por lo que es importante comprender los principios básicos de cómo funcionan y en qué se diferencian entre sí. Aquí presentamos los principios básicos detrás de las tecnologías de cámaras digitales comúnmente encontradas en la imagen científica.

Fundamentos

La tarea de un sensor de imagen es convertir una señal óptica en una señal eléctrica. Este principio se basa en el llamado efecto fotovoltaico, que describe cómo los fotones interactúan con el material para liberar un electrón que resulta en la acumulación de carga. En la mayoría de las cámaras, el silicio es el sustrato utilizado para este propósito. En todos los casos, un electrón se libera de su enlace mediante la absorción de un fotón. Las propiedades naturales del silicio lo hacen ideal como el componente principal de la unidad elemental de la mayoría de los sensores.

Píxel

Independientemente del tipo de sensor, se puede considerar el píxel como la unidad básica. El elemento principal de un píxel es el fotodiodo fotosensible con silicio acoplado a un pozo de almacenamiento de electrones. El silicio es responsable de generar los electrones, que luego se pueden recoger, mover y finalmente convertir en una señal digital. Los componentes adicionales de un píxel incluyen circuitos de control eléctrico y capas de pigmentos para excluir longitudes de onda no deseadas o destructivas. Durante el proceso de imagen, los fotones que impactan en los fotodiodos se convierten en electrones. Estos electrones se almacenan en los pozos de almacenamiento de electrones para su transferencia posterior, la lectura, al amplificador. El amplificador lee los electrones acumulados y los transforma en un voltaje, mientras que el convertidor analógico-digital (AD) adyacente realiza la digitalización y produce señales digitales equivalentes.

La carga generada en un píxel es directamente proporcional al número de fotones que golpean el sensor, lo cual suele estar influenciado por la duración de la exposición a la luz (tiempo de integración), la longitud de onda detectada y, lo más importante, la intensidad de la luz. Como regla general, el tamaño del píxel define la cantidad de electrones que se pueden recoger sin saturar un píxel. El tamaño de los píxeles varía típicamente entre 2-24 µm² para sensores de imagen en microscopía.

Debido a las arquitecturas típicas de los píxeles, no toda la superficie de un píxel es fotosensible. El factor de llenado de un sensor de imagen describe la relación entre el área fotosensible de un píxel y su área total. Se pueden agregar micro lentes a un píxel para enfocar mejor la luz en las regiones fotosensibles, mejorando el factor de llenado.

Un sensor de imagen digital completo consta de millones de píxeles organizados en una matriz geométrica. A menudo, se confunde el número de píxeles con «resolución». Es importante destacar que no es simplemente el número de píxeles, sino su tamaño lo que define la resolución del chip de la cámara. En general, píxeles más pequeños ofrecerán una mayor resolución que los grandes. En última instancia, la resolución de una Un sensor completo de imagen digital consta de millones de píxeles organizados en una matriz geométrica. Con frecuencia, se confunde el número de píxeles con «resolución». Es importante destacar que no es simplemente el número de píxeles, sino su tamaño lo que define la resolución del chip de la cámara. En general, píxeles más pequeños proporcionarán una mayor resolución que los más grandes. En última instancia, la resolución de un sistema de microscopía no depende solo del conjunto de sensores, sino del sistema óptico completo.

Ruido y relación señal-ruido

Desafortunadamente, el ruido es un elemento fundamental de la física que afecta todas las señales. El impacto y el tipo de ruido dominante varían según los tipos de sensores. En general, se puede clasificar el ruido de la cámara en tres clases principales según su origen:

1. Ruido oscuro: también conocido como corriente oscura, es un ruido fundamental presente en el sensor debido a la energía térmica en el silicio que genera electrones de manera aleatoria en los píxeles. Este tipo de ruido se acumula con el tiempo de exposición y se expresa en electrones por píxel por segundo (e-/px/seg). Es menos preocupante para aplicaciones rápidas con tiempos de exposición cortos, pero puede convertirse en un problema importante para tiempos de exposición largos, por ejemplo, un segundo o más para señales fluorescentes débiles. La reducción del ruido oscuro se logra enfriando el sensor, reduciendo a la mitad la corriente oscura con cada 8 grados de enfriamiento.

2. Ruido de lectura: proviene de la circuitería eléctrica de lectura del sensor involucrada en cuantificar la señal. Como regla general, el ruido de lectura se puede reducir disminuyendo la velocidad de lectura del píxel, que define qué tan rápido se puede leer la carga del sensor (unidad: MHz). Dado que esto determina la velocidad de cuadros de la cámara, el ruido de lectura debe tenerse en cuenta para experimentos rápidos, como el lapso de tiempo de células vivas de alta velocidad.

3. Ruido de conteo de fotones: es otra fuente de ruido basada en la incertidumbre al contar los fotones entrantes. Surge de la naturaleza estocástica de los impactos de los fotones en el sensor, pero no es introducido por el sensor en sí. Se puede visualizar como una distribución de Poisson al detectar fotones en el chip.

Bajo condiciones de poca luz, como en la imagen de fluorescencia cuando la intensidad de la señal es baja, las diferentes fuentes de ruido pueden tener un impacto importante en la calidad de la imagen, ya que afectan la relación señal-ruido. Utilizar la cámara adecuada para la aplicación es esencial para capturar imágenes de calidad. La relación señal-ruido (SNR) es una medida de la calidad general de una imagen, que está fuertemente influenciada por el tipo de sensor. En términos generales, se puede designar como su sensibilidad. Aunque esto puede ser bastante complejo, la SNR expresa qué tan bien se distingue una señal de interés del ruido de fondo.

Capacidad del pozo

La capacidad del pozo depende en gran medida del tamaño físico del píxel. Se refiere a la capacidad de almacenamiento de carga de un solo píxel, es decir, el número máximo de electrones que puede recoger antes de saturarse. Alcanzar la capacidad completa del pozo se puede comparar con un cubo lleno de agua. Los píxeles más grandes tienen una capacidad completa del pozo mayor que los píxeles pequeños (típicamente 18,000 e- para un píxel de 6.45 µm frente a 300,000 e- para un píxel de 24 µm). La resolución espacial se sacrifica por la mayor capacidad completa del pozo, lo que a su vez influye en el rango dinámico.

Los electrones que exceden la capacidad completa del pozo no se pueden cuantificar. En algunos casos, la carga puede filtrarse hacia los píxeles adyacentes, causando un efecto conocido como florecimiento. Algunos sensores contienen electrónicos anti florecimiento que intentan eliminar la carga excesiva para suprimir artefactos de florecimiento.

Rango dinámico

Una característica directamente relacionada con la capacidad completa del pozo es el rango dinámico. Esto describe la capacidad del sensor para registrar simultáneamente señales de baja y alta intensidad. En un sentido práctico, esto significa que la señal más débil no se pierde en el ruido y la señal más brillante no satura el sensor. Expresado en términos matemáticos, el rango dinámico se define como la capacidad completa del pozo (FWC) dividida por el ruido de la cámara.

La mejora del rango dinámico se logra si la capacidad completa del pozo es mayor y el ruido de la cámara es menor. En una primera aproximación, se puede decir que los siguientes parámetros afectan el rango dinámico:

1. Tamaño del píxel (Capacidad completa del pozo)

2. Temperatura (Ruido oscuro)

3. Tasa de lectura (Ruido de lectura)

Para aplicaciones de fluorescencia, un rango dinámico grande es un beneficio importante para documentar señales brillantes de fluorescencia contra un fondo oscuro (Fig. 7), especialmente al cuantificar señales. El rango dinámico se ve directamente afectado por la ganancia aplicada. El término «ganancia» se usa aquí para expresar la amplificación de una señal generada. Si, por ejemplo, duplicas la ganancia de tu sensor, efectivamente reduces a la mitad la capacidad completa del pozo, lo que a su vez disminuye el rango dinámico. Por lo tanto, a menudo se requiere un equilibrio entre sensibilidad y rango dinámico.

Si el rango dinámico inherente del sensor no es suficiente para la aplicación, o el espécimen, se puede considerar una adquisición de «alto rango dinámico» (HDR). Durante este procedimiento, se adquiere una serie de imágenes con intensidades de exposición variables. La imagen resultante se calcula finalmente aplicando diferentes algoritmos. La desventaja de este enfoque es el tiempo prolongado necesario para adquirir las imágenes. Por lo tanto, esto no es preferible para muestras que se mueven rápidamente o son sensibles a la luz.

Eficiencia cuántica

En un mundo ideal, se asumiría que 100 fotones son capaces de generar 100 electrones. Al interactuar con un sensor, los fotones pueden ser absorbidos, reflejados o incluso pasar directamente a través. La capacidad de un sensor para absorber y convertir la luz de una longitud de onda determinada en electrones se conoce como su eficiencia cuántica (QE).

La eficiencia cuántica de un sensor se ve afectada por varios factores, incluyendo:

1. Factor de llenado

2. Adición / rendimiento de micro lentes

3. Recubrimiento antirreflejante

4. Formato del sensor (iluminado por la parte trasera o delantera)

La eficiencia cuántica es siempre una función de la longitud de onda de la luz entrante. Los detectores de silicio, más comúnmente utilizados en imágenes científicas, pueden detectar longitudes de onda justo más allá del rango de luz visible (~400 a 1000 nm). Al observar una curva de eficiencia cuántica, puedes ver cuán eficiente es un sensor específico para convertir una longitud de onda particular en una señal (Fig. 9). La mayoría de los sensores de cámaras están iluminados por la parte delantera, donde la luz incidente entra desde el frente del píxel, teniendo que pasar capas semitransparentes que contienen la circuitería de los píxeles, antes de golpear el silicio fotosensible. Estas capas causan cierta pérdida de luz, por lo que los sensores iluminados por la parte delantera suelen tener eficiencias cuánticas máximas alrededor del 50-60%. Dado que la electrónica en la superficie de los sensores solo puede generar un campo eléctrico localizado, no puede manipular la carga que se forma más profundamente en la oblea de silicio.

En el caso de un sensor iluminado por la parte trasera, la luz golpea directamente el silicio fotosensible desde la «parte trasera» sin tener que pasar por la circuitería del píxel, ofreciendo eficiencias cuánticas máximas que se acercan al 95%. Para fabricar sensores iluminados por la parte trasera, también conocidos como retroiluminados, este silicio adicional se muele, un proceso costoso, para crear una capa de silicio increíblemente delgada donde todos los píxeles pueden manipular la carga de manera efectiva.

Profundidad de bits

La profundidad de bits puede relacionarse con, pero no debe confundirse con el rango dinámico, y se refiere a cómo se digitaliza, o se divide, la señal analógica en valores de escala de grises o niveles de grises. La profundidad de bits depende de la capacidad del convertidor AD para transformar la cantidad de electrones generados en valores de escala de grises. Cuantos más niveles de grises pueda producir, más detalles se pueden reproducir.

Algunas cámaras ofrecen más valores de escala de grises de los necesarios para el número máximo de electrones que pueden generar los fotones (por ejemplo, una digitalización de 16 bits divide la señal en ~65,000 unidades de escala de grises). En circunstancias extremas, el sensor puede saturarse por debajo de 1,000 fotones/píxel, pero la imagen aún muestra 65,000 valores de escala de grises. Además, las pantallas de computadora suelen ser capaces de mostrar datos de 8 bits. Es por eso que una señal de cámara con más de 8 bits debe reducirse para mostrarse. Los usuarios pueden influir en este proceso con la ayuda de la tabla de búsqueda (LUT). Jugar con ella a menudo revela detalles ocultos en una imagen.

Velocidad de imagen y binning

La velocidad de imagen de una cámara digital se mide en tasas de cuadros indicadas en cuadros por segundo (fps). Este es el número de imágenes (cuadros) que la cámara puede adquirir en un segundo. Muchos factores pueden afectar la velocidad máxima alcanzable de una cámara. En un tiempo de exposición dado, se deben considerar los siguientes parámetros:

1. Recuento de píxeles

2. Tasa de lectura de píxeles

3. Interfaz de la computadora

Resumen

La microscopía óptica moderna sería impensable sin la tecnología de cámaras digitales. La mayoría de los usuarios de microscopios desean observar sus especímenes en tiempo real en un monitor o guardar y procesar sus descubrimientos en una computadora. Además, algunas técnicas microscópicas, como la microscopía de localización, ni siquiera habrían sido posibles sin el surgimiento de los sensores de cámaras digitales. El lector de este artículo debería haber aprendido cómo se producen las imágenes microscópicas digitales. Esto, a su vez, ayudará a utilizar una cámara digital adecuadamente y a interpretar los datos generados de la manera correcta.

Fuente:

DeRose, J., Greb, C., Laskey, P., Schwab, K., & Müller, C. (2023, December 14). Technical terms for digital microscope cameras and image analysis. Science Lab | Leica Microsystems. https://www.leica-microsystems.com/science-lab/microscopy-basics/technical-terms-for-digital-microscope-cameras-and-image-analysis/